2. 다음 SQL문 실행결과는? (실제 시험에스는 전항 정답 처리 되었지만 확정답안 발표를 참고하여 문제를 적절히 수정하여 정상적으로 문제를 풀수 있도록 조치 하였습니다.)

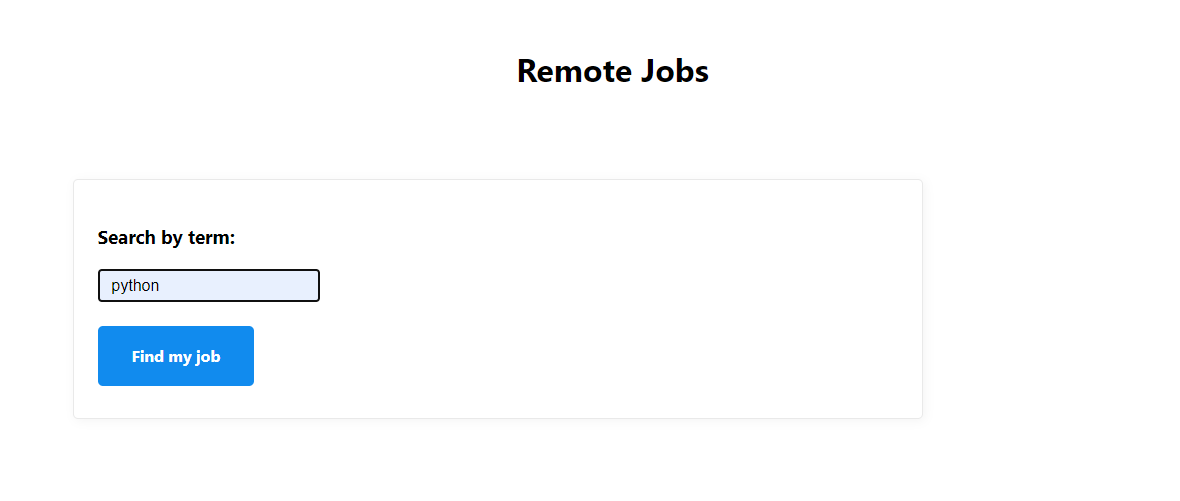

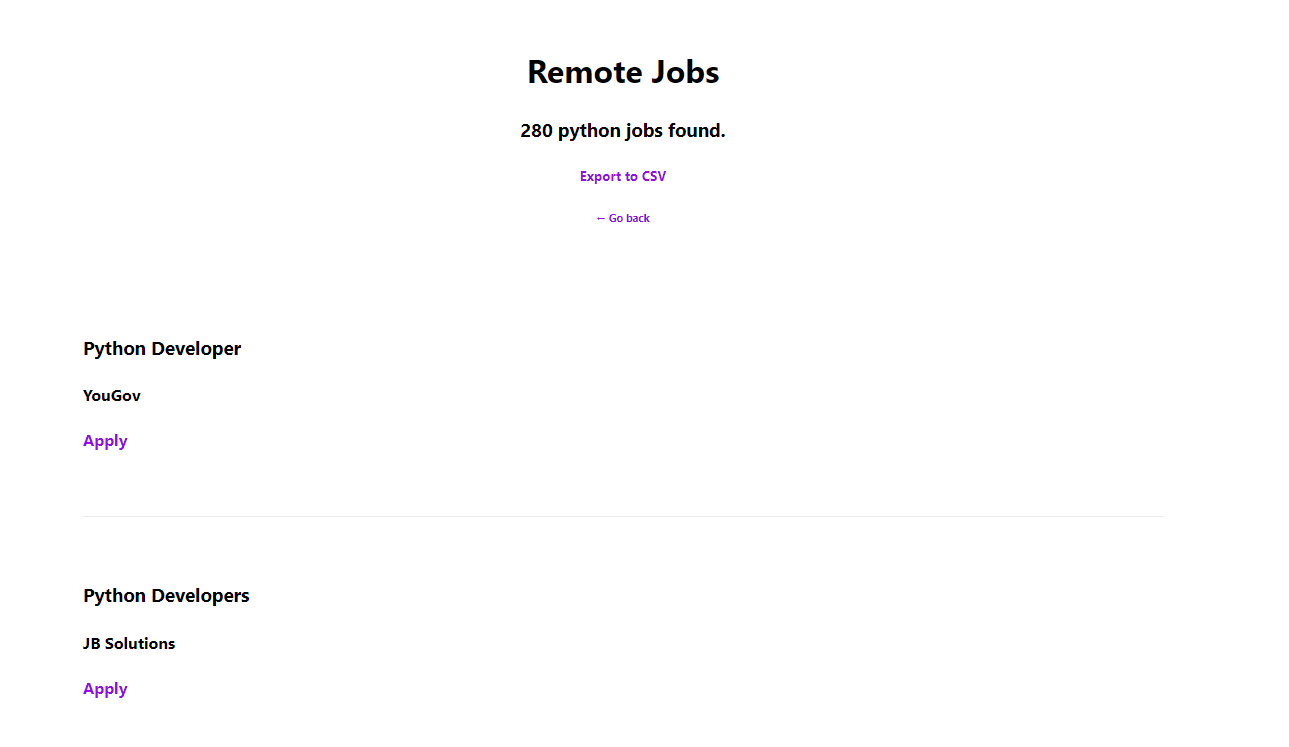

SELECT A.학번, A.이름, B.학점

FROM 학생 A, 성적 B

WHERE A.학번 = B.학번 AND B.과목이름 = "DB"

FROM

1) 학생 테이블을 A로 이름을 붙혀 주었다

2) 성적 테이블을 B로 이름을 붙혀 주었다

WHERE 에서 붙혀주기를 해주었다

1) 학번이 같은 것 끼리 묵어주었다

AND

2) 과목 이름이 "DB" 인것만 추출하였다

SELECT

1) 학생에서 학번 출럭

2) 학생에서 이름 출력

3) 성적에서 학점 출럭

단 과목이름이 "DB"인것만

답은 (4)번

'자격증 공부 > 정보처리기사' 카테고리의 다른 글

| [정보처리기사] 2017년 03월 05일 필기 기출문제 6번 (0) | 2020.09.12 |

|---|---|

| [정보처리기사] 2017년 03월 05일 필기 기출문제 5번 (0) | 2020.09.12 |

| [정보처리기사] 2017년 03월 05일 필기 기출문제 4번 (0) | 2020.09.12 |

| [정보처리기사] 2017년 03월 05일 필기 기출문제 3번 (0) | 2020.09.12 |

| [정보처리기사] 2017년 03월 05일 필기 기출문제 1번 (0) | 2020.09.12 |